เสียงเหมือนจนน่ากลัว! AI ปลอมเสียงหลอกโอนเงิน

- ประเด็นสำคัญที่ต้องจับตา

- ภัยคุกคามยุคใหม่: เมื่อเสียงที่คุ้นเคยไม่ใช่เรื่องจริง

- รู้จัก Voice Cloning: เทคโนโลยีเบื้องหลังเสียงปลอม

- กลยุทธ์และรูปแบบการโจมตีที่พบบ่อย

- มูลค่าความเสียหายและผลกระทบทางเศรษฐกิจ

- แนวทางการป้องกันและวิธีรับมือเมื่อต้องเผชิญหน้า

- บทสรุป: สร้างเกราะป้องกันภัยไซเบอร์ด้วยความรอบคอบ

เทคโนโลยีปัญญาประดิษฐ์ (AI) ได้เข้ามามีบทบาทในชีวิตประจำวันมากขึ้น แต่ในขณะเดียวกันก็เปิดช่องทางให้มิจฉาชีพนำไปใช้เป็นเครื่องมือในการหลอกลวงรูปแบบใหม่ โดยเฉพาะการใช้ AI ปลอมเสียงเพื่อสร้างสถานการณ์ฉุกเฉินและหลอกให้โอนเงิน ซึ่งสร้างความเสียหายเป็นวงกว้าง

ประเด็นสำคัญที่ต้องจับตา

- เทคโนโลยี Voice Cloning สามารถสร้างเสียงปลอมที่เหมือนจริงจนแยกได้ยาก โดยใช้ตัวอย่างเสียงเพียงสั้นๆ

- มิจฉาชีพมักใช้เสียงปลอมแอบอ้างเป็นบุคคลใกล้ชิด เช่น คนในครอบครัวหรือเพื่อน เพื่อสร้างความน่าเชื่อถือและเร่งรัดให้เหยื่อตัดสินใจโอนเงิน

- มูลค่าความเสียหายจากกลโกงที่ใช้ AI เพิ่มสูงขึ้นอย่างมีนัยสำคัญ และกลายเป็นหนึ่งในรูปแบบการโจมตีทางไซเบอร์ที่สร้างความเสียหายสูงสุด

- การป้องกันที่ดีที่สุดคือการตั้งสติ ไม่ตื่นตระหนก และตรวจสอบยืนยันตัวตนของผู้ที่ติดต่อมาทุกครั้งก่อนทำธุรกรรมทางการเงิน

- ภัยคุกคามนี้ไม่ได้จำกัดอยู่แค่การหลอกโอนเงิน แต่ยังรวมถึงการสร้างข่าวปลอมและทำลายชื่อเสียงของบุคคลอื่น

ภัยคุกคามยุคใหม่: เมื่อเสียงที่คุ้นเคยไม่ใช่เรื่องจริง

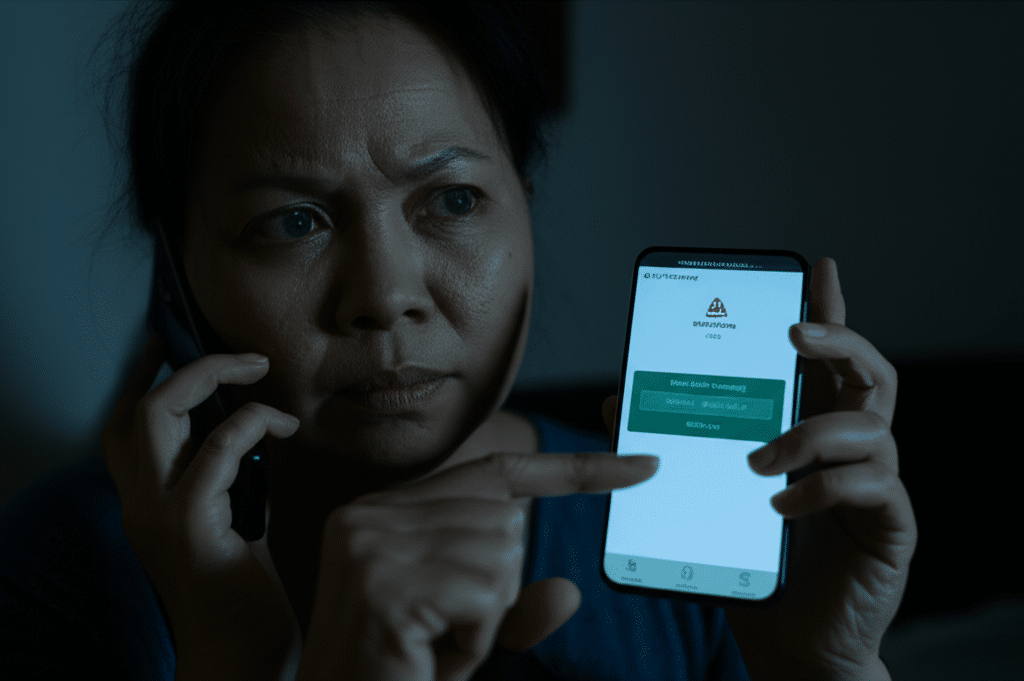

ภัยคุกคามทางไซเบอร์ที่น่ากังวลอย่างยิ่งในปัจจุบันคือการที่ เสียงเหมือนจนน่ากลัว! AI ปลอมเสียงหลอกโอนเงิน กลายเป็นเครื่องมือหลักของแก๊งคอลเซ็นเตอร์และมิจฉาชีพออนไลน์ เทคโนโลยีนี้ทำให้การหลอกลวงมีความซับซ้อนและน่าเชื่อถือมากขึ้นกว่าเดิมหลายเท่า เพราะแทนที่จะเป็นเสียงที่ไม่คุ้นเคย มิจฉาชีพกลับใช้เสียงของคนที่เหยื่อรักและไว้ใจโทรมาขอความช่วยเหลือในสถานการณ์คับขัน เช่น อ้างว่าประสบอุบัติเหตุ หรือต้องการเงินด่วนเพื่อแก้ไขปัญหาเฉพาะหน้า

ความสมจริงของเสียงที่สร้างขึ้นโดย AI ทำให้เหยื่อเกิดความตื่นตระหนกและขาดความยับยั้งชั่งใจ ส่งผลให้หลงเชื่อและโอนเงินไปอย่างง่ายดาย กลโกงลักษณะนี้จึงไม่ใช่เรื่องไกลตัวอีกต่อไป แต่เป็นภัยที่สามารถเกิดขึ้นได้กับทุกคน ทุกเพศ ทุกวัย และกำลังแพร่หลายอย่างรวดเร็วในสังคม

ความสำคัญของการตระหนักรู้ในยุคดิจิทัล

การพัฒนาของเทคโนโลยี AI ทำให้ข้อมูลเสียงที่เผยแพร่อยู่บนโลกออนไลน์ เช่น คลิปวิดีโอในโซเชียลมีเดีย หรือการให้สัมภาษณ์ สามารถถูกนำไปใช้เป็นต้นแบบในการสร้างเสียงปลอมได้อย่างง่ายดาย ดังนั้น การตระหนักรู้ถึงความเสี่ยงและเข้าใจกลไกของภัยคุกคามรูปแบบใหม่นี้จึงเป็นสิ่งสำคัญอย่างยิ่ง การเผยแพร่ความรู้และแนวทางการป้องกันจะช่วยลดโอกาสการตกเป็นเหยื่อและสร้างสังคมดิจิทัลที่ปลอดภัยยิ่งขึ้น

กลุ่มเป้าหมายของมิจฉาชีพ

แม้ว่าทุกคนจะมีความเสี่ยง แต่กลุ่มที่มิจฉาชีพมักพุ่งเป้าเป็นพิเศษคือผู้สูงอายุ ซึ่งอาจไม่คุ้นเคยกับเทคโนโลยีและมีแนวโน้มที่จะเชื่อใจคนง่าย นอกจากนี้ กลุ่มคนที่มีความห่วงใยคนในครอบครัวสูงก็เป็นเป้าหมายหลักเช่นกัน เพราะมิจฉาชีพจะใช้ความรักและความเป็นห่วงเป็นเครื่องมือในการบีบคั้นทางอารมณ์ ทำให้การตัดสินใจขาดความรอบคอบและนำไปสู่การสูญเสียทรัพย์สินในที่สุด

รู้จัก Voice Cloning: เทคโนโลยีเบื้องหลังเสียงปลอม

เทคโนโลยีที่อยู่เบื้องหลังการสร้างเสียงปลอมที่เหมือนจริงนี้มีชื่อเรียกว่า “Voice Cloning” หรือการโคลนนิ่งเสียง ซึ่งเป็นแขนงหนึ่งของการพัฒนาปัญญาประดิษฐ์ที่มุ่งเน้นการสังเคราะห์เสียงพูดของมนุษย์ให้มีความเป็นธรรมชาติมากที่สุด

Voice Cloning คืออะไร?

Voice Cloning คือกระบวนการใช้ AI โดยเฉพาะแบบจำลองการเรียนรู้เชิงลึก (Deep Learning) เพื่อวิเคราะห์และเลียนแบบลักษณะเฉพาะของเสียงบุคคลใดบุคคลหนึ่ง เช่น ระดับเสียง, ความเร็วในการพูด, น้ำเสียง และสำเนียง จากนั้น AI จะสร้างแบบจำลองทางคณิตศาสตร์ของเสียงนั้นขึ้นมา ทำให้สามารถสังเคราะห์คำพูดใหม่ๆ ด้วยเสียงของบุคคลต้นแบบได้ตามต้องการ โดยที่บุคคลนั้นไม่เคยพูดประโยคดังกล่าวจริง

กระบวนการสร้างเสียงสังเคราะห์

ในอดีต การสร้างเสียงสังเคราะห์คุณภาพสูงจำเป็นต้องใช้ข้อมูลเสียงต้นแบบจำนวนหลายชั่วโมง แต่ด้วยความก้าวหน้าของ AI ในปัจจุบัน มิจฉาชีพต้องการตัวอย่างเสียงของเป้าหมายเพียงไม่กี่วินาทีหรือไม่กี่นาทีเท่านั้น ซึ่งสามารถหาได้ง่ายจากแพลตฟอร์มออนไลน์ทั่วไป เช่น Facebook, Instagram, TikTok หรือ YouTube เมื่อได้ไฟล์เสียงตัวอย่างแล้ว AI จะทำการแยกองค์ประกอบและเรียนรู้รูปแบบเสียง ก่อนจะพร้อมใช้งานในการสร้างบทสนทนาหลอกลวงที่แนบเนียนจนแทบแยกไม่ออก

กลยุทธ์และรูปแบบการโจมตีที่พบบ่อย

มิจฉาชีพได้พัฒนากลยุทธ์การใช้ AI ปลอมเสียงอย่างหลากหลาย เพื่อเพิ่มโอกาสในการหลอกลวงให้สำเร็จ โดยอาศัยจุดอ่อนด้านอารมณ์และความไว้วางใจของมนุษย์เป็นหลัก

การแอบอ้างเป็นคนในครอบครัวหรือเพื่อนสนิท

รูปแบบที่แพร่หลายและสร้างความเสียหายมากที่สุดคือการที่มิจฉาชีพใช้เสียงโคลนนิ่งของลูกหลาน ญาติ หรือเพื่อนสนิท โทรหาเหยื่อพร้อมกับสร้างเรื่องราวที่น่าตกใจ เช่น

- สถานการณ์ฉุกเฉิน: อ้างว่าประสบอุบัติเหตุร้ายแรงและต้องการเงินค่ารักษาพยาบาลด่วน

- ปัญหาทางการเงิน: อ้างว่าถูกจับกุมและต้องการเงินประกันตัว หรือทำของมีค่าหายและต้องการเงินเพื่อเดินทางกลับบ้าน

- ความผิดพลาดในการทำธุรกรรม: อ้างว่าโอนเงินผิดบัญชีและขอให้โอนคืนอย่างเร่งด่วน

ความตื่นตระหนกและเป็นห่วงทำให้เหยื่อไม่มีเวลาไตร่ตรอง และรีบโอนเงินตามที่มิจฉาชีพร้องขอ

การปลอมเสียงบุคคลสาธารณะเพื่อหลอกลงทุน

อีกรูปแบบหนึ่งคือการใช้ AI ปลอมเสียงของบุคคลที่มีชื่อเสียง ผู้นำประเทศ หรือนักธุรกิจที่ประสบความสำเร็จ เพื่อสร้างความน่าเชื่อถือในการชักชวนให้ลงทุนในโครงการปลอมๆ มิจฉาชีพอาจสร้างคลิปเสียงหรือวิดีโอ (Deepfake) ที่มีบุคคลเหล่านั้นกล่าวสนับสนุนแพลตฟอร์มการลงทุนที่ไม่มีอยู่จริง โดยสัญญาว่าจะให้ผลตอบแทนสูงในระยะเวลาสั้นๆ เพื่อล่อลวงให้ผู้คนหลงเชื่อและโอนเงินลงทุนเข้าไป

ผลกระทบต่อชื่อเสียงและวงการอื่นๆ

นอกจากการหลอกลวงทางการเงินแล้ว เทคโนโลยี AI ปลอมเสียงยังถูกนำไปใช้ในทางที่ผิดเพื่อทำลายชื่อเสียงของผู้อื่นได้อีกด้วย เช่น กรณีของบุคคลในวงการบันเทิงหรือนักพากย์ที่ถูกนำเสียงไปดัดแปลงโดยไม่ได้รับอนุญาต เพื่อสร้างเนื้อหาที่ไม่เหมาะสมหรือบิดเบือนความจริง ซึ่งส่งผลกระทบโดยตรงต่อภาพลักษณ์และอาชีพการงานของบุคคลนั้นๆ และอาจนำไปสู่การฟ้องร้องทางกฎหมายเพื่อปกป้องสิทธิ์ของตนเอง

| คุณสมบัติ | กลโกงคอลเซ็นเตอร์แบบดั้งเดิม | กลโกงด้วย AI ปลอมเสียง |

|---|---|---|

| วิธีการหลัก | ใช้คนจริงโทรศัพท์ อ้างเป็นเจ้าหน้าที่รัฐหรือสถาบันการเงิน | ใช้เสียงที่สังเคราะห์โดย AI เลียนแบบเสียงคนใกล้ชิดหรือบุคคลน่าเชื่อถือ |

| ความน่าเชื่อถือ | ปานกลาง เหยื่ออาจสงสัยในน้ำเสียงหรือสำเนียงที่ไม่คุ้นเคย | สูงมาก เสียงที่เหมือนจริงทำให้เหยื่อหลงเชื่อได้ง่ายและรวดเร็ว |

| กลไกทางจิตวิทยา | สร้างความกลัว (เช่น กลัวถูกดำเนินคดี) หรือความโลภ (เช่น ได้รับรางวัล) | สร้างความตื่นตระหนกและความเป็นห่วง (เช่น คนรักประสบอุบัติเหตุ) |

| ความยากในการตรวจจับ | ตรวจจับได้ง่ายกว่า หากเหยื่อมีสติและตรวจสอบกับหน่วยงานที่ถูกอ้างอิง | ตรวจจับได้ยากมากในเบื้องต้น เนื่องจากเสียงที่ได้ยินมีความคุ้นเคยสูง |

มูลค่าความเสียหายและผลกระทบทางเศรษฐกิจ

การใช้ AI ในการหลอกลวงทางการเงินได้ยกระดับความรุนแรงของปัญหาอาชญากรรมทางไซเบอร์ไปอีกขั้น ข้อมูลจากหน่วยงานที่เกี่ยวข้องระบุว่ากลโกงที่เกี่ยวข้องกับการใช้เทคโนโลยีขั้นสูงเช่นนี้ได้สร้างความเสียหายเป็นอย่างมาก

ในช่วงปี 2565 ถึง 2568 คาดการณ์ว่ามูลค่าความเสียหายรวมจากอาชญากรรมออนไลน์ โดยเฉพาะการหลอกลวงทางการเงินที่ใช้เทคโนโลยี AI เข้ามาเกี่ยวข้อง มีมูลค่ารวมหลายหมื่นล้านบาท และถูกจัดให้เป็นหนึ่งในรูปแบบการโจมตีที่สร้างความเสียหายทางเศรษฐกิจสูงสุด

ตัวเลขดังกล่าวสะท้อนให้เห็นถึงผลกระทบในวงกว้าง ไม่ใช่แค่การสูญเสียทรัพย์สินของปัจเจกบุคคล แต่ยังบ่อนทำลายความเชื่อมั่นในระบบการสื่อสารและธุรกรรมออนไลน์โดยรวมอีกด้วย ความเสียหายนี้ไม่ได้หยุดอยู่แค่ตัวเงิน แต่ยังรวมถึงผลกระทบทางจิตใจของเหยื่อที่ต้องเผชิญกับความเครียดและความรู้สึกผิดที่ถูกหลอกลวง

แนวทางการป้องกันและวิธีรับมือเมื่อต้องเผชิญหน้า

แม้ว่าเทคโนโลยีของมิจฉาชีพจะมีความซับซ้อน แต่การป้องกันตัวเองจากการตกเป็นเหยื่อสามารถทำได้ด้วยความรอบคอบและการมีสติอยู่เสมอ การเตรียมพร้อมรับมือจะช่วยลดความเสี่ยงได้อย่างมีประสิทธิภาพ

สัญญาณเตือนที่ต้องสังเกต

เมื่อได้รับการติดต่อทางโทรศัพท์ที่น่าสงสัย แม้ว่าจะเป็นเสียงที่คุ้นเคย ให้ลองสังเกตสัญญาณเตือนเหล่านี้:

- การสร้างความกดดันและเร่งรัด: มิจฉาชีพมักจะสร้างสถานการณ์ที่บีบคั้นให้ต้องตัดสินใจและโอนเงินทันที โดยไม่ให้เวลาในการไตร่ตรอง

- เรื่องราวที่แปลกและไม่คาดคิด: เรื่องราวที่ดูรุนแรงเกินจริงหรือเป็นปัญหาที่ไม่น่าจะเกิดขึ้นกับคนๆ นั้น

- การร้องขอข้อมูลส่วนตัวหรือรหัสผ่าน: การสนทนาที่นำไปสู่การขอข้อมูลทางการเงิน เช่น รหัส OTP หรือรหัสผ่านแอปพลิเคชันธนาคาร

- คุณภาพเสียงที่ผิดปกติ: แม้ AI จะทำเสียงได้เหมือนจริง แต่บางครั้งอาจมีเสียงรบกวน การหยุดพูดที่ผิดจังหวะ หรือน้ำเสียงที่ราบเรียบไร้อารมณ์ผิดปกติ

- การปฏิเสธที่จะวิดีโอคอล: หากร้องขอให้เปิดกล้องเพื่อยืนยันตัวตน แต่มิจฉาชีพมักจะบ่ายเบี่ยงโดยอ้างเหตุผลต่างๆ

ขั้นตอนการตรวจสอบเพื่อความปลอดภัย

หากพบสัญญาณเตือนหรือรู้สึกไม่แน่ใจ ให้ปฏิบัติตามขั้นตอนต่อไปนี้ทันที:

- วางสายทันที: ไม่ต้องกลัวว่าจะเสียมารยาท หากรู้สึกสงสัยให้วางสายก่อนเป็นอันดับแรก

- ติดต่อกลับไปยังเบอร์โทรศัพท์ที่บันทึกไว้: ห้ามโทรกลับไปยังเบอร์ที่โทรเข้ามาเด็ดขาด ให้ใช้เบอร์โทรศัพท์ของบุคคลนั้นๆ ที่บันทึกไว้ในรายชื่อผู้ติดต่อของตัวเองเพื่อโทรกลับไปตรวจสอบข้อเท็จจริง

- ตั้งคำถามยืนยันตัวตน: ถามคำถามที่รู้กันเฉพาะสองคน เช่น “เมื่อวานเราคุยกันเรื่องอะไร” หรือ “ร้านอาหารที่เราไปกินด้วยกันครั้งล่าสุดชื่ออะไร” ซึ่งเป็นข้อมูลที่มิจฉาชีพไม่มีทางรู้

- สร้าง “รหัสปลอดภัย” (Safe Word): ตกลงกับคนในครอบครัวเพื่อตั้งคำหรือวลีลับที่ใช้ยืนยันตัวตนในสถานการณ์ฉุกเฉิน หากผู้ที่ติดต่อมาไม่สามารถบอกรหัสนี้ได้ ก็สันนิษฐานได้ว่าเป็นมิจฉาชีพ

- ปรึกษาผู้อื่น: อย่าตัดสินใจเพียงลำพัง ลองปรึกษาเพื่อนหรือสมาชิกคนอื่นๆ ในครอบครัวเพื่อช่วยกันพิจารณา

บทสรุป: สร้างเกราะป้องกันภัยไซเบอร์ด้วยความรอบคอบ

ภัยจาก AI ปลอมเสียงหลอกโอนเงิน คือความท้าทายครั้งสำคัญในยุคดิจิทัลที่ทุกคนต้องเผชิญ เทคโนโลยีที่ก้าวหน้าได้กลายเป็นดาบสองคมที่มิจฉาชีพนำมาใช้ประโยชน์เพื่อสร้างความเดือดร้อนและความเสียหายอย่างมหาศาล ความเหมือนจริงของเสียงที่ถูกสังเคราะห์ขึ้นมานั้นสามารถทำลายกำแพงแห่งความไว้วางใจและทำให้ผู้คนตกเป็นเหยื่อได้ในชั่วพริบตา

อย่างไรก็ตาม อาวุธที่ดีที่สุดในการต่อสู้กับภัยคุกคามนี้คือ “สติ” และ “ความรอบคอบ” การไม่ตื่นตระหนกไปกับเรื่องราวที่น่าตกใจ การตรวจสอบข้อมูลให้ถี่ถ้วนก่อนตัดสินใจ และการสื่อสารกับคนในครอบครัวอยู่เสมอ คือเกราะป้องกันที่แข็งแกร่งที่สุด การตระหนักรู้และแบ่งปันข้อมูลเกี่ยวกับกลโกงรูปแบบใหม่ๆ ให้คนรอบข้างได้รับทราบ จะช่วยสร้างภูมิคุ้มกันให้กับสังคมโดยรวม และลดโอกาสที่ใครจะต้องตกเป็นเหยื่อของอาชญากรรมทางไซเบอร์ที่นับวันจะยิ่งทวีความรุนแรงขึ้น